Mục lục

Cuộc đua phần cứng phục vụ cho trí tuệ nhân tạo (AI) chưa bao giờ hạ nhiệt, và mới đây, một báo cáo thử nghiệm thực tế đã làm chấn động giới công nghệ. Hệ thống máy chủ AI Blackwell GB200 NVL72 của Nvidia vừa trải qua các bài kiểm tra khắc nghiệt trong môi trường mô hình “Hỗn hợp Chuyên gia” (MoE – Mixture of Experts). Kết quả thu được cho thấy đại diện của đội Xanh đã bỏ xa đối thủ cạnh tranh trực tiếp là Instinct MI355X của AMD với một khoảng cách hiệu năng khổng lồ lên tới 28 lần. Điều này không chỉ khẳng định sức mạnh phần cứng của Nvidia mà còn cho thấy hiệu quả kinh tế vượt trội mà họ mang lại cho các doanh nghiệp công nghệ.

Thiết kế đồng bộ giúp Nvidia GB200 NVL72 vượt qua rào cản MoE

Hiện nay, các mô hình AI đang có sự chuyển dịch nhanh chóng sang kiến trúc tập trung vào MoE (Mixture of Experts). Lý do chính cho xu hướng này là khả năng tận dụng tài nguyên tính toán hiệu quả hơn nhiều so với các mô hình truyền thống. Tuy nhiên, việc mở rộng quy mô của các mô hình MoE lại tạo ra một nút thắt cổ chai lớn về khả năng tính toán so với các mô hình dày đặc (dense models). Do MoE tập trung vào việc vận hành các mạng lưới phụ riêng biệt được dán nhãn là các “chuyên gia”, nó đòi hỏi một lượng giao tiếp khổng lồ giữa tất cả các điểm nút và nhu cầu truyền tải dữ liệu liên tục. Chính đặc thù này đã gây ra các vấn đề nghiêm trọng về độ trễ và tạo áp lực lớn lên băng thông hệ thống.

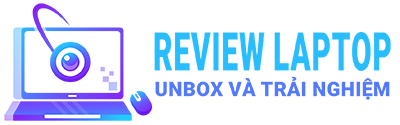

Các gã khổng lồ về điện toán đám mây (hyperscalers) luôn tìm kiếm giải pháp tối ưu nhất về hiệu năng trên mỗi đô la bỏ ra. Theo một phân tích chuyên sâu từ Signal65, hệ thống GB200 NVL72 của Nvidia hiện đang là lựa chọn hàng đầu cho các kiến trúc MoE nhờ vào định luật “Đồng thiết kế cực đoan” (Extreme Co-Design). Dẫn chứng từ các điểm chuẩn của SemiAnalysis InferenceMAX, báo cáo chỉ ra rằng các máy chủ AI Blackwell của Nvidia đã mang lại thông lượng cao gấp 28 lần trên mỗi GPU (đạt mức 75 token/giây) so với AMD MI355X trong một cấu hình cụm tương tự.

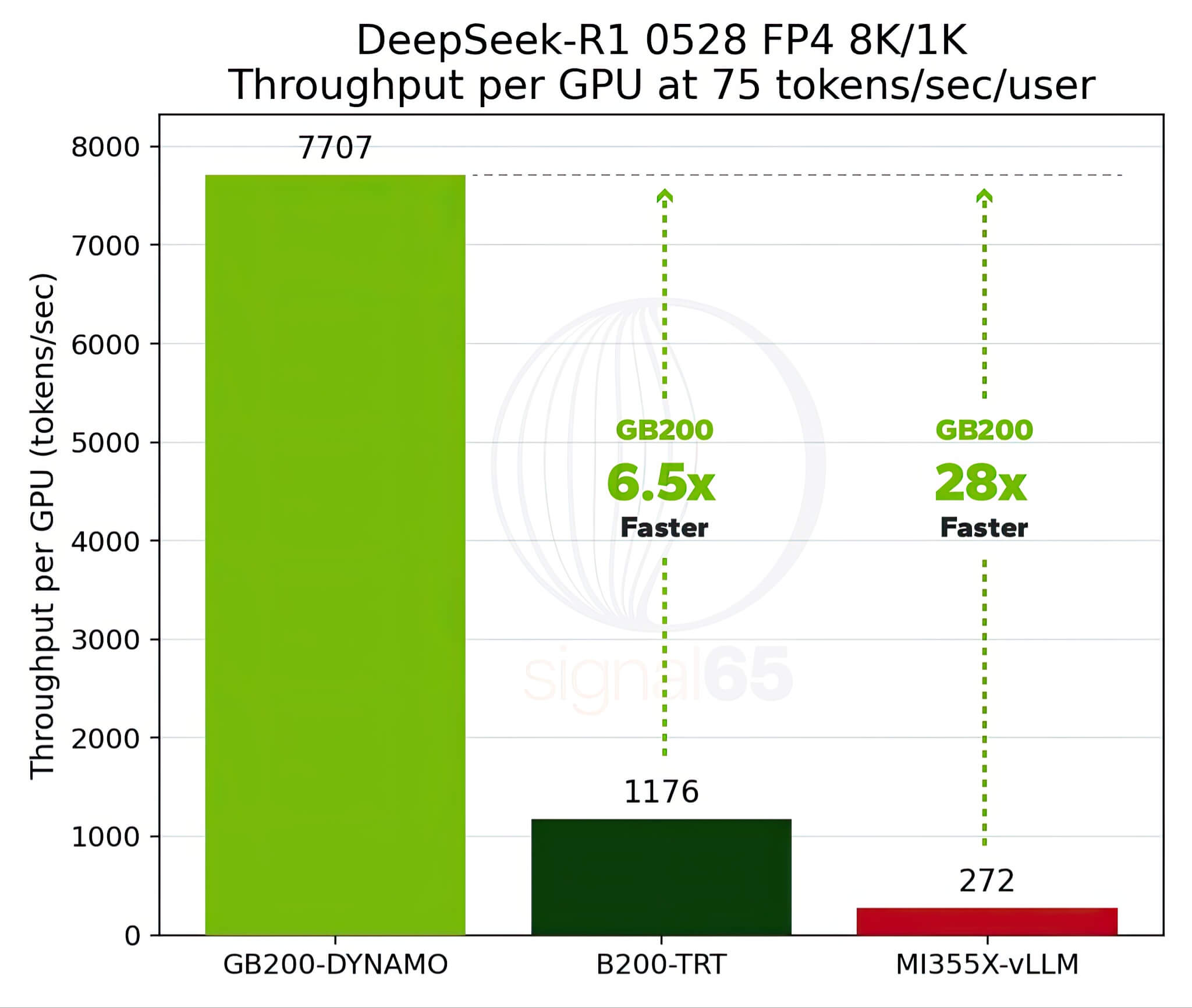

Nếu bạn tò mò tại sao lại có sự chênh lệch khủng khiếp đến vậy, thì câu trả lời nằm ở cách tiếp cận của Nvidia. Để giải quyết các nút thắt hiệu năng khi mở rộng mô hình AI MoE, Nvidia đã áp dụng phương pháp đồng thiết kế, sử dụng cấu hình 72 chip kết hợp với GB200, đi kèm với đó là 30TB bộ nhớ chia sẻ tốc độ cao. Sự kết hợp phần cứng này cho phép Nvidia đưa khả năng xử lý song song của các “chuyên gia” AI lên một tầm cao hoàn toàn mới, giúp dữ liệu lưu thông mượt mà và giảm thiểu tối đa độ trễ.

Lợi thế về chi phí vận hành và cuộc đua chip AI tương lai

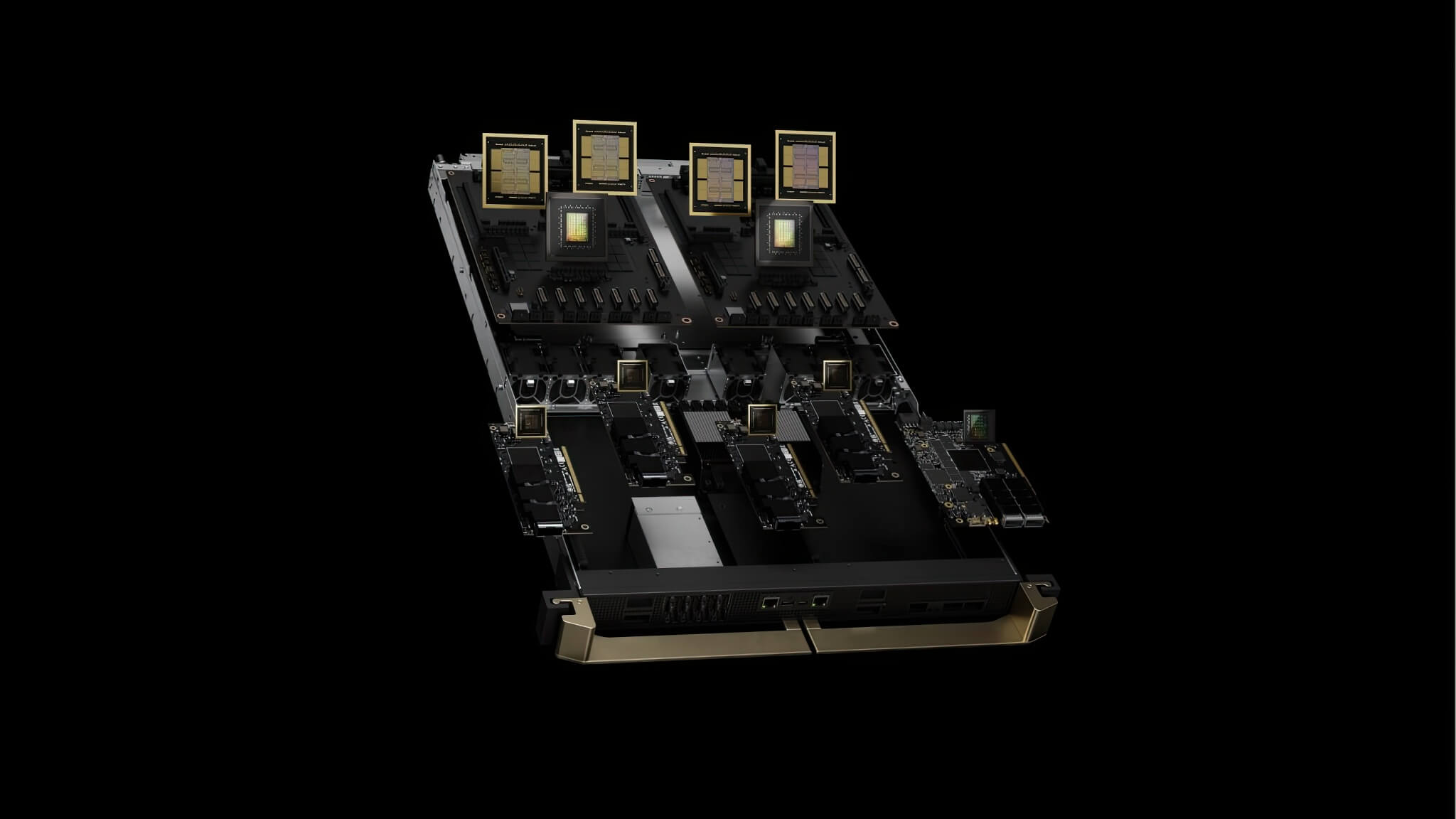

Trong kinh tế học AI, yếu tố quyết định thường nằm ở việc kiến trúc nào có thể cung cấp chỉ số Tổng chi phí sở hữu (TCO) tốt hơn. Theo dữ liệu từ Signal65 trích dẫn bảng giá của Oracle Cloud, các tủ máy chủ GB200 NVL72 của Nvidia cung cấp mức chi phí tương đối trên mỗi token thấp hơn đáng kinh ngạc, chỉ bằng 1/15 so với đối thủ, trong khi vẫn duy trì tốc độ tương tác cao hơn. Đây chính là lý do giải thích tại sao ngăn xếp phần cứng của Nvidia lại là một trong những giải pháp được áp dụng rộng rãi nhất hiện nay.

Một bảng so sánh chi tiết về các chỉ số hiệu năng và chi phí giữa GB200 NVL72 và MI355X đã làm nổi bật sự thống trị của Nvidia. Cụ thể, GB200 NVL72 có “Lợi thế Hiệu năng trên Đô la” cao gấp 3,1 lần ở mức xử lý 25 token/giây và lên tới gấp 15 lần ở mức 75 token/giây. Đối với một công ty hoạt động theo nhịp độ sản phẩm hàng năm như Nvidia, họ đang quản lý để thống trị mọi biên giới AI mới mở ra, từ suy luận, điền trước (prefill) cho đến giải mã (decode), cho phép họ duy trì khoảng cách an toàn với những kẻ bám đuổi.

Tất nhiên, những con số này chưa phải là bức tranh toàn cảnh đại diện cho toàn bộ cuộc tranh luận giữa AMD và Nvidia trong không gian AI, bởi lẽ “Đội Đỏ” AMD vẫn chưa giới thiệu thế hệ sản phẩm quy mô tủ máy chủ (rack-scale) mới hơn của mình. Các sản phẩm MI355X Instinct của AMD vẫn được biết đến là một lựa chọn mạnh mẽ trong các môi trường mô hình dày đặc nhờ vào dung lượng bộ nhớ HBM3e cao. Tuy nhiên, khi xét riêng về kiến trúc MoE đang thịnh hành, Nvidia hiện đang nắm giữ vị thế độc tôn. Với các giải pháp quy mô tủ máy chủ trong tương lai (cuộc đối đầu giữa Helios và Vera Rubin), sự cạnh tranh chắc chắn sẽ còn khốc liệt hơn nữa.