Mục lục

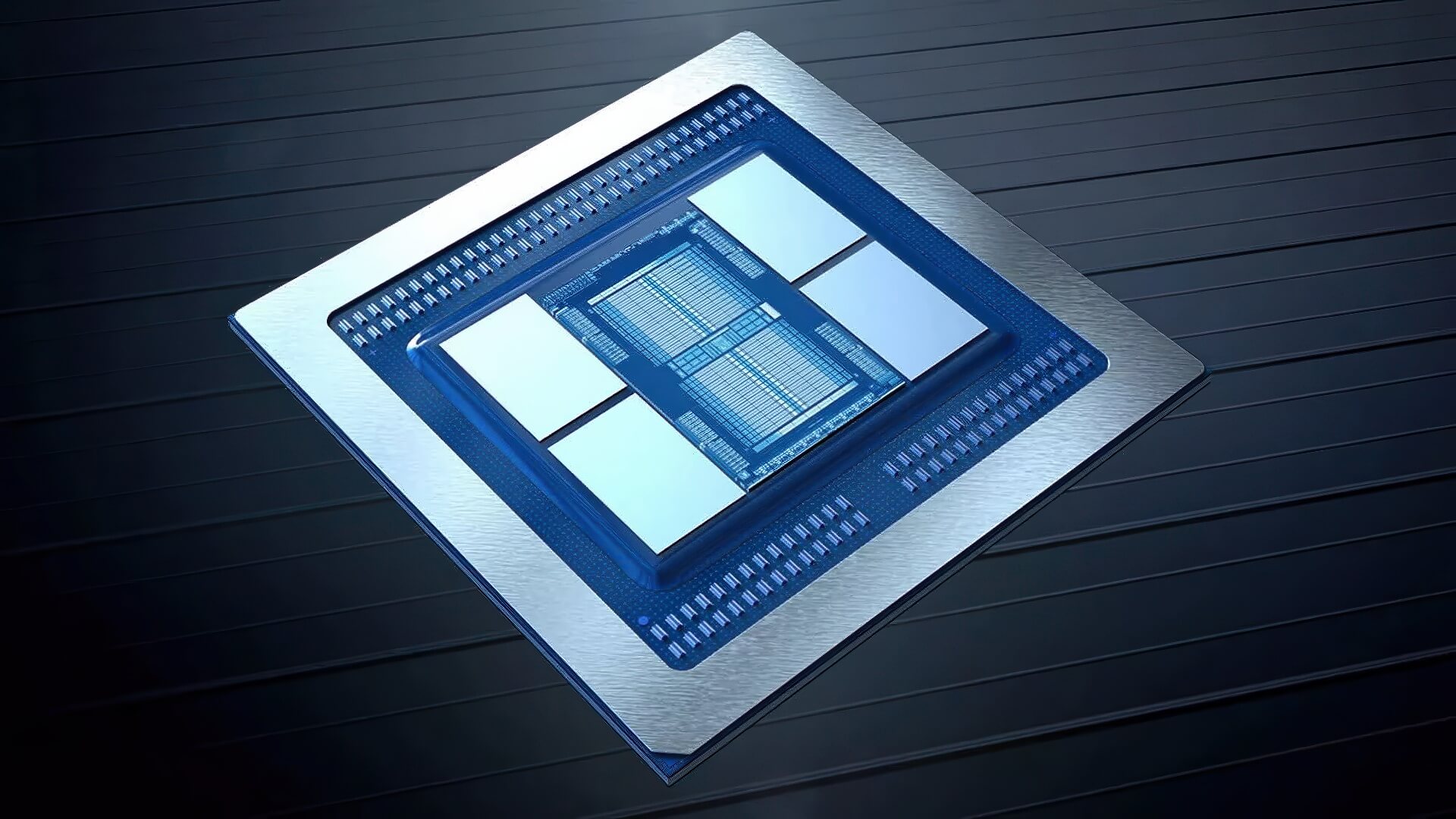

Samsung Electronics, nhà sản xuất bộ nhớ lớn nhất thế giới, đã chính thức vượt qua các trở ngại kỹ thuật để sản xuất chip HBM3E, mở đường trở thành nhà cung ứng cho Nvidia – hãng đang dẫn đầu trong lĩnh vực máy chủ AI hiệu năng cao.

Samsung hoàn tất kiểm định HBM3E của Nvidia

Trong nhiều năm qua, Samsung sở hữu năng lực sản xuất bán dẫn toàn diện, nhưng lại chật vật trong việc đáp ứng yêu cầu khắt khe từ Nvidia cho dòng bộ nhớ băng thông cao HBM3E. Theo nguồn tin từ KED Global, Samsung đã giải quyết thành công các vấn đề kỹ thuật và vượt qua bài kiểm định nghiêm ngặt từ Nvidia, cho phép hãng chính thức gia nhập chuỗi cung ứng chip bộ nhớ AI hàng đầu.

Được biết, Samsung đã phát triển HBM3E từ khoảng 18 tháng trước, song các phiên bản đầu tiên không đạt chuẩn hiệu năng do gặp vấn đề về nhiệt. Đầu năm nay, ông Jun Young-hyun, lãnh đạo mảng bán dẫn của Samsung, đã yêu cầu thiết kế lại lõi DRAM. Sự điều chỉnh này giúp xử lý triệt để các lỗi quá nhiệt, mở ra cơ hội để sản phẩm được Nvidia chấp thuận.

Với thành công này, Samsung trở thành nhà cung cấp HBM3E thứ ba cho Nvidia, bên cạnh SK hynix và Micron. Tuy nhiên, sản lượng ban đầu sẽ khá hạn chế và vai trò của Samsung trong ngắn hạn vẫn mang tính bổ sung hơn là chính yếu. Các chuyên gia nhận định đây là dấu mốc quan trọng, thể hiện vị thế công nghệ của Samsung thay vì chỉ tập trung vào doanh thu.

HBM3E và cuộc đua trong ngành bộ nhớ AI

HBM3E là loại bộ nhớ có băng thông cực cao, được thiết kế đặc biệt cho các hệ thống AI cần khả năng xử lý khối lượng dữ liệu khổng lồ. AMD hiện đã sử dụng HBM3E của Samsung trong dòng tăng tốc MI350, trong khi Nvidia cũng dự kiến tích hợp loại bộ nhớ này vào các máy chủ B300, phục vụ huấn luyện và suy luận AI ở quy mô lớn.

Công nghệ HBM3E vốn được SK hynix giới thiệu lần đầu năm 2023 và hiện đang được triển khai trong các bộ tăng tốc trung tâm dữ liệu dùng GPU Blackwell của Nvidia. Tuy nhiên, ngành công nghiệp đã bắt đầu hướng sự chú ý sang HBM4 – thế hệ bộ nhớ mới được JEDEC chuẩn hóa vào tháng 4/2025. Đây được coi là bước tiến tiếp theo để nâng hiệu năng và khả năng tiết kiệm điện của hệ thống AI.

Theo các chuyên gia trong ngành, Samsung đang cho thấy những tín hiệu khả quan với HBM4. Công ty dự kiến gửi những mẫu chip HBM4 đầu tiên cho Nvidia kiểm định ngay trong tháng này, qua đó tham gia sâu hơn vào cuộc đua toàn cầu trong lĩnh vực bộ nhớ băng thông cao.

Việc Samsung vượt qua các rào cản để cung cấp HBM3E cho Nvidia không chỉ củng cố vị thế của hãng trong ngành bán dẫn, mà còn khẳng định tham vọng duy trì chỗ đứng trong kỷ nguyên AI, nơi nhu cầu về hiệu năng tính toán và bộ nhớ tốc độ cao ngày càng bùng nổ.